Το τηλέφωνο χτυπά. Όταν το σηκώνεις, στην άλλη άκρη της γραμμής ακούγεται μια πολύ γνώριμη σε σένα φωνή, ενός αγαπημένου σου ανθρώπου. Σου ζητά απεγνωσμένα βοήθεια. Χάνεις την ψυχραιμία σου και μπορεί να κάνεις ό,τι σου ζητήσει – από αποστολή χρημάτων μέχρι και πρόσβαση στον τραπεζικό σου λογαριασμό. Κάπως έτσι, έχεις πέσει θύμα τηλεφωνικής απάτης.

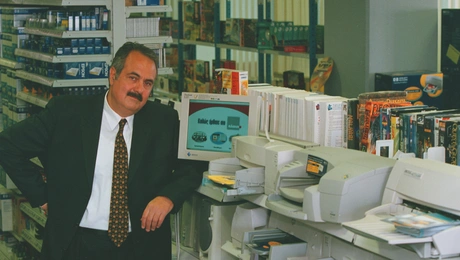

Τα τελευταία χρόνια, με την εξέλιξη της Τεχνητής Νοημοσύνης, οι τηλεφωνικές απάτες βρίσκονται σε έξαρση. «Μεγάλος αριθμός εκθέσεων δείχνει ετήσια αύξηση 450% σε απάτες κλωνοποίησης φωνής από το 2023 στο 2024, ενώ μεταξύ τελευταίου τριμήνου 2024 και πρώτου τριμήνου 2025 αναφέρεται αύξηση της τάξεως του 1600% -αύξηση 17 φορές- στον αντίστοιχο αριθμό», λέει στο reader o Διονύσης Ξενάκης, επίκουρος καθηγητής του ΕΚΠΑ – Τμήμα Τεχνολογιών Ψηφιακής Βιομηχανίας.

Πλαστοπροσωπία spoofing και άλλες μέθοδοι εξαπάτησης

Τα περιστατικά αυτά, είναι πλέον καθημερινά. «Ο όγκος τέτοιων συμβάντων είναι πλέον τεράστιος και πολλοί συμπολίτες μας, ακόμα και όσοι είναι καλά πληροφορημένοι ή έχουν ευχέρεια στη χρήση νέων τεχνολογιών, έχουν πέσει θύματα τέτοιων επιθέσεων, αφού μέσα στην πιεσμένη καθημερινότητα που ζούμε, δεν μπορούμε να σκεφτούμε σε βάθος το καθετί», επισημαίνει.

Όπως εξηγεί, η τεχνητή νοημοσύνη δεν εισήγαγε νέες μορφές απάτης, αλλά ενίσχυσε τις γνωστές τεχνικές εξαπάτησης που ήδη γνωρίζαμε. Πλαστοπροσωπία, κοινωνική μηχανική, spoofing και γενικότερα παιχνίδια με την εμπιστοσύνη, την αυθεντία, την αίσθηση του επείγοντος, την έκκληση σε βοήθεια. Με όλα τα νέα εργαλεία που φέρνει η ΑΙ, τα οποία είναι διαθέσιμα πλέον στον καθένα στο Διαδίκτυο, οι απάτες γίνονται πιο πειστικές, εφαρμόζονται αμεσότερα και μπορούν να κλιμακώσουν ή να συνδυαστούν σε πρωτοφανή επίπεδα.

«Η πλέον διαδεδομένη τεχνική εξαπάτησης λέγεται πλαστοπροσωπία (Impersonation), στην οποία ο επιτιθέμενος παριστάνει ένα πρόσωπο που σεβόμαστε, εμπιστευόμαστε, υπηρετούμε ή αγαπάμε. Η ΑΙ του επιτρέπει να δημιουργήσει αποσπάσματα φωνής με σκοπό να μας εξαπατήσει. Η φωνή ή το πρόσωπο σε μία επικοινωνία δεν αποτελούν πλέον ασφαλές αποδεικτικό ταυτότητας. Εργαλεία για κλωνοποίηση φωνής (voice cloning), συγχρονισμού χειλιών σε βίντεο (lip syncing) και παραγωγής βίντεο με παραλλαγμένο περιεχόμενο (deepfakes) αποτελούν τη βάση για επιθέσεις πλαστοπροσωπίας και εξαπάτησης (π.χ., voice phishing / vishing)».

Παράλληλα, υπάρχει η Κοινωνική Μηχανική (Social Engineering), βάσει της οποίας στοχεύουν στις αδυναμίες των ανθρώπων και στη χειραγώγησή τους με διαχείριση συναισθημάτων όπως ο φόβος, η εμπιστοσύνη κτλ. Υπάρχουν νέα εργαλεία ΑΙ που μπορούν να προσαρμόζουν τον λόγο και τον τόνο της φωνής σε πραγματικό χρόνο για να επιτύχουν το επιθυμητό αποτέλεσμα.

Όπως αναφέρει ο κ. Ξενάκης, πολλές φορές η επίθεση γίνεται με την αξιοποίηση πληροφοριών για κατασκευή πειστικών ιστοριών (Pretexting). «Είναι μακράν πιο αποτελεσματική όταν βασίζεται σε πραγματικά στοιχεία και δεδομένα για τη ζωή του θύματος, για τη δημιουργία μίας πειστικής ιστορίας που θα οδηγήσει τον στόχο εκεί που θέλει ο επιτιθέμενος. Η επιτυχία της μεθόδου αυτής δεν βασίζεται τόσο στην τεχνολογία, όσο στην συλλογή πληροφοριών για τον στόχο από social media, ιστοσελίδες, γειτονιά κλπ».

Επιπλέον υπάρχει η παραποίηση ταυτότητας καναλιού (Spoofing), που αφορά την τεχνική παραποίησης της ταυτότητας του μέσου επικοινωνίας.

«Αυτό μπορεί να αφορά την παρουσίαση ενός παρόμοιου αριθμού τηλεφώνου, μία παραπλήσια διεύθυνση ηλεκτρονικού ταχυδρομείου ή ακόμα και μία γνώριμη σελίδα στο διαδίκτυο (τράπεζα, social media κλπ). Το θύμα νιώθει οικειότητα και κρίνει ότι αναγνωρίζει το μέσο επικοινωνίας χωρίς αυτό να ανταποκρίνεται στην πραγματικότητα. Εδώ η ΑΙ χρησιμοποιείται για πιο στοχευμένη αναγνώριση τηλεφώνων, διευθύνσεων ηλεκτρονικού ταχυδρομείου, κατασκευή ιστοσελίδων και περιεχομένου σχεδόν σε πραγματικό χρόνο, αλλάζοντας την κλίμακα και το εύρος της επίθεσης».

Υπάρχουν και οι επιθέσεις σε πολλά βήματα και σε διαφορετικά επίπεδα (multi-stage attacks), που γίνονται σε στόχους υψηλής αξίας -επιχειρήσεις, ιδρύματα, φυσικά πρόσωπα με περιουσία. «Μία αυτοματοποιημένη αναζήτηση στοιχείων του προφίλ ενός εργαζομένου στο LinkedIn ή ενός ιδιώτη στο Instagram/Facebook, μπορεί να δημιουργήσει το απαραίτητο περιεχόμενο για pretexting. Αξιοποιώντας δείγματα φωνής, εικόνας αλλά και το περιεχόμενο αυτό, μπορεί να ακολουθήσει μία φάση εμπέδωσης εμπιστοσύνης μέσω μικρών και φαινομενικά αθώων αλληλεπιδράσεων», σημειώνει ο κ. Ξενάκης.

«Το πιο σημαντικό στοιχείο που οδηγεί σε εκθετική αύξηση ηλεκτρονικών απατών, είναι η ευκολία στησίματος μία τέτοιας απάτης. Διότι χωρίς κανένα τεχνικό υπόβαθρο, ειδικό εξοπλισμό ή εγκατάσταση λογισμικού, ο οποιοσδήποτε πλέον μπορεί με στοιχεία που θα αντλήσει από το Διαδίκτυο και εργαλεία που είναι δωρεάν και διαθέσιμα online, να συλλέξει προσωπικές μας πληροφορίες, να αποκτήσει πρόσβαση σε στοιχεία για βιομετρικά μας χαρακτηριστικά (φωνή, ύψος, βάρος, εικόνα, βίντεο) και να δημιουργήσει πειστικό περιεχόμενο προς εξαπάτησης μας (κλωνοποιημένη φωνή, deepfaked video). Αυτό, σε συνδυασμό με την ισχαιμική πληροφόρηση και εκπαίδευση του κοινού, είναι η ρίζα του προβλήματος», προσθέτει.

Αύξηση απατών κατά 1600%

Αντλώντας στοιχεία από την Ετήσια Έκθεση Ηλεκτρονικής Εγκληματικότητας του FBI (2024), την εκτίμηση κινδύνου από οργανωμένο ηλεκτρονικό έγκλημα της Europol, άρθρα και εκθέσεις από εταιρίες τεχνολογίας (IBM, righ-hand.ai, DeepStrike.io κλπ), ο κ. Ξενάκης αναφέρει πως «μεγάλος αριθμός εκθέσεων δείχνει ετήσια αύξηση 450% σε απάτες κλωνοποίησης φωνής από το 2023 στο 2024, ενώ μεταξύ τελευταίου τριμήνου 2024 και πρώτου τριμήνου 2025 αναφέρεται αύξηση της τάξεως του 1600% (αύξηση 17 φορές) στον αντίστοιχο αριθμό.

Επίσης 7 στους 10 οργανισμούς θα στοχοποιηθούν οδηγώντας σε κατάρρευση των συστημάτων τους για περισσότερες από 7 ημέρες, ενώ 1 στους 4 πολίτες θα την «πατήσουν» σε απάτες με κλωνοποίηση φωνής, με συμπολίτες μας στην ηλικία 60+ να αυξάνουν το ποσοστό αυτό σε 6 στους 10. Η μέση οικονομική απώλεια ανά επιτυχημένη επίθεση θα είναι περίπου 1400 ευρώ, ενώ έχουν γίνει γνωστά τα αποτελέσματα απατών με απώλειες μέχρι και 25 εκατομμύρια δολάρια».

Τα red flags της κλωνοποίησης φωνής

Μέχρι σήμερα υπάρχουν ατέλειες στα εργαλεία κλωνοποίησης φωνής ή παραλλαγής του περιεχομένου του βίντεο και ψηφιακά ίχνη. Σύμφωνα με τον κ. Ξενάκη, οι ατέλειες περιλαμβάνουν περίεργες παύσεις, αφύσικο ρυθμό στην ομιλία, καθυστερημένες απαντήσεις μετά από ερώτηση μας, απότομη αλλαγή θέματος, έλλειψη ιδιαίτερων χαρακτηριστικών στην ομιλία όπως βαριά «νι» και «λι» ή απουσία λέξεων εκφράσεων που σχετίζονται με γλωσσικά ιδιώματα του ομιλητή. Αντίστοιχα, όταν έχουμε εικόνα, θα παρατηρήσουμε μικρές αφύσικες αλλαγές στην κίνηση των χειλιών, χρονικές στιγμές που είτε όλη η εικόνα είτε σημεία αυτής απορρυθμίζονται (pixeling, flickering, κλπ), περίεργα αντικείμενα στις σκηνή και πολύ κλασσικό υπόβαθρο.

Κάθε πολίτης μπορεί να αξιολογήσει ως red flags τα σημάδια χρονικής ή ψυχολογικής πίεσης για να έρθουμε σε δράση σε συνδυασμό με συναισθηματική φόρτιση, αναφορά σε ονόματα και καταστάσεις που βιώσαμε από τρίτους για να κάμψουν τη δυσπιστία μας και να έρθουμε σε δράση, σπάσιμο τυπικών διαδικασιών και πρωτοκόλλων στη λειτουργία της επιχείρησης μας, έστω και με αθώα πρόφαση.

«Ωστόσο η τεχνολογία βελτιώνεται συνεχώς, άρα δεν μπορούμε να βασιστούμε σε γνωστές ατέλειες. Και αυτό γιατί ανάλογα τον στόχο και τα κίνητρα της επίθεσης μπορεί να γίνει τελειοποίηση του περιεχομένου που παράγει η ΑΙ, είναι χρονικά αδύνατον τα μέσα επιβολής του νόμου να ακολουθούν τα ψηφιακά ίχνη για καθεμία από τις χιλιάδες επιθέσεις που συμβαίνουν και πολλές φορές δεν είμαστε υποψιασμένοι ή δεν έχουμε χρόνο στην καθημερινότητα να αξιολογήσουμε μια συζήτηση».

Τι πρέπει να κάνουμε για να μην πέσουμε «θύματα» απάτης

Αρχικά «πρέπει να μάθουμε εμείς πρώτα και ύστερα τα παιδιά μας, να κάνουμε ηθική χρήση εργαλείων ΑΙ. Να μην δημοσιοποιούμε προσωπικές πληροφορίες, ηχητικά και εικόνα των μικρών μας φίλων. Το να κόψουμε στους εφήβους την πρόσβαση σε Διαδίκτυο και social media είναι δραστικό μέτρο, αλλά όχι λύση. Καλύτερα με έξυπνη διαχείριση, ενημέρωση, συγκεκριμένα χρονικά πλαίσια, συναινετικά αλλά όχι καταστολή.

Να είναι σαφές στα παιδιά μας πως ότι και να μας πουν με ηλεκτρονικά μέσα (τηλέφωνο, μήνυμα, ηχητικό, email) ποτέ δεν προχωρούμε σε άμεσες ενέργειες. Πρέπει να δώσουμε χρόνο για να επιβεβαιώσουμε με δεύτερο κανάλι επικοινωνίας ότι υπάρχει η ανάγκη. Ένα μήνυμα ή ένα τηλέφωνο από αυτόν που κλήθηκε σε δράση, στον αριθμό αυτού που τον κάλεσε σε δράση».

Παράλληλα, να εμπιστευόμαστε τους αριθμούς που έχουμε αποθηκευμένους, να έχουμε φράσεις κλειδιά για να χρησιμοποιούμε όταν υπάρχει ανάγκη, να μην αποκαλύπτουμε προσωπικά βιώματα όταν δεχόμαστε άγνωστες κλήσεις και να κάνουμε ανορθόδοξες ερωτήσεις στους (ηλεκτρονικούς) συνομιλητές μας, για να διαπιστώνουμε αν συνομιλούμε με φυσικά ή τεχνητά πρόσωπα», σημειώνει.

Σε ό,τι αφορά την προστασία των ηλικιωμένων που πέφτουν συχνά θύματα απάτης, ο κ. Ξενάκης επισημαίνει πως «οι άνθρωποι 65+ μεγάλωσαν σε ένα κόσμο που η φωνή και η εικόνα ήταν πειστήρια. Η απομόνωση των ηλικιωμένων είναι βασικότερος σύμμαχος για μία επιτυχή απάτη. Οπότε πρέπει να είμαστε δίπλα τους και να τους εξηγήσουμε ότι ούτε η φωνή ούτε η εικόνα είναι απόδειξη ταυτοπροσωπίας, να μην εμπιστεύονται άγνωστους αριθμούς ή κλήσεις με άγνωστα ονόματα, να έχουν σε κρίσιμες πλατφόρμες - όπως τράπεζες και βασικά emails- πιστοποίηση σε βήματα (κωδικός + μήνυμα, 2-factor authentication) και όρια στις οικονομικές συναλλαγές τους».

Πως τα social media ευνοούν τις απάτες

«Όπως σε όλες τις περιστάσεις, η υπερέκθεση δημιουργεί κινδύνους. Η ψηφιακή παρουσία οφείλει να είναι μία συνειδητή επιλογή, αν και αναπόφευκτη. Μπορεί ένα βίντεο 5 δευτερολέπτων στο TikTok ή το Instagram να αποτελέσει υλικό για κλωνοποίηση φωνής. Νομίζω πως πλέον οι χρήστες των social media σε μεγάλο βαθμό είναι ώριμοι και κατανοούν τους κινδύνους που απορρέουν από τη χρήση τους. Τα μέρη που επισκεπτόμαστε, ό,τι περιλαμβάνεται στις φωτογραφίες μας αποτελούν υλικό που μπορεί να είναι αλλάξει τις ισσοροπίες κάνοντας μία απάτη πιο πειστική ή για κάποιο οικείο μας πρόσωπο, ακόμα και τον οργανισμό στον οποίο εργαζόμαστε.

Αν πρέπει κάτι να πω, θα παρότρυνα τους ανθρώπους να μην δημοσιεύουν ήχο, φωτογραφίες και βίντεο από ανηλίκους σε προεφηβική φάση, γιατί είναι ιδιαίτερα ευάλωτοι. Επίσης, οι δημοσιεύσεις μας καλό θα ήταν να μην περιλαμβάνουν στοιχεία που εκθέτουν την τοποθεσία, την περιουσία ή την κατάσταση μας καθώς μπορεί να αξιοποιηθούν για να προσβάλλουν οικεία μας πρόσωπα».

Κίνδυνος χειραγώγησης της δημοκρατίας

Όπως λέει ο κ. Ξενάκης, το βασικότερο είναι να μη βασιζόμαστε σε οικείες φωνές για να δράσουμε. «Επιφανής Ιταλός επιχειρηματίας δέχθηκε τηλεφώνημα από επιτήδειους, οι οποίοι κλωνοποίησαν τη φωνή υψηλόβαθμου στελέχους της Ιταλικής κυβέρνησης με το οποίο διατηρούσε φιλικές σχέσεις. Στο τηλεφώνημα το στέλεχος της Ιταλικής κυβέρνησης ζήτησε άμεση μεταφορά 1 εκατ. ευρώ για την πληρωμή λύτρων σε απαγωγείς, που υποτίθεται είχαν απαγάγει γνωστούς δημοσιογράφους. Η απάτη ολοκληρώθηκε επιτυχώς».

Οι ηλεκτρονικές απάτες είναι πολυδιάστατες και δεν βασίζονται υποχρεωτικά σε χρονική πίεση. Μεγάλος οργανισμός με καζίνο και ξενοδοχεία στις ΗΠΑ, υπέστη οικονομικές απώλειες της τάξης των 100 εκατ. δολαρίων, λόγω απάτης σε στάδια. Οι επιτήδειοι αναζήτησαν προφίλ εργαζομένων σε πλατφόρμα επαγγελματικής δικτύωσης, συνέλεξαν πληροφορίες, «πλαστογράφησαν» έναν εργαζόμενο, κλωνοποίησαν τη φωνή του και έπεισαν το Γραφείο Τεχνικής Υποστήριξης Χρηστών του οργανισμού να δώσει πρόσβαση σε λογαριασμούς του πλαστο-προσωποιημένου υπαλλήλου. Έτσι απέκτησαν πρόσβαση σε κρίσιμες ηλεκτρονικές υποδομές cloud της εταιρείας, οδηγώντας σε κλείδωμα και δυσλειτουργία τους με αίτημα λύτρων».

Επιπλέον, «υπάρχει ακόμα και κίνδυνος χειραγώγησης της κοινωνίας και της δημοκρατίας. Στις πρόσφατες προεδρικές εκλογές των ΗΠΑ, κυκλοφόρησε ηχητικό με κλωνοποιημένη φωνή του Μπαϊντεν να καλεί τους ψηφοφόρους του να μην ψηφίσουν στις τοπικές εκλογές σε ένδειξη διαμαρτυρίας. Αντίστοιχα, στη Σλοβακία κυκλοφόρησε παραλλαγμένο πολυμεσικό περιεχόμενο (deepfake video) που απεικόνιζε υποψήφιο βουλευτή να χρηματίζεται, οδηγώντας σε πιθανή αλλοίωση του εκλογικού αποτέλεσματος (δεν εκλέχθηκε)». Άρα πρέπει η κοινωνία να εκπαιδευτεί και κάθε οργανισμός να έχει δικό του σχέδιο προστασίας απέναντι σε τέτοιες απάτες.

Όπως λέει καταλήγοντας, «η φωνή και η εικόνα μας πλέον δεν αποτελούν πειστήρια για εμπέδωση της εμπιστοσύνης. Η ΑΙ δεν είναι όπλο εναντίον μας, αλλά εργαλείο ενδυνάμωσης που αν αξιοποιηθεί σωστά, θα μας υπηρετήσει. Ωστόσο, σε καμία περίπτωση δεν πρέπει να εφησυχαστούμε και να θεωρούμε πως η χρήση της ΑΙ μπορεί να φέρει μόνο καλό. Πρέπει να επιταχυνθεί η εφαρμογή της δράσης για την ΑΙ και πρέπει όλοι να είμαστε ενεργοί πολίτες - τόσο δίπλα όσο και απέναντι στην ΑΙ. Δε φοβόμαστε να αναπτύξουμε νέες δεξιότητες και να μετασχηματιζόμαστε ως κοινωνία και ως άνθρωποι. Ωστόσο, δεν πρέπει να αφήνουμε σημαντικές δεξιότητες μας να χάνονται».

Ακολουθήστε το Reader στα Google News για να είστε πάντα ενημερωμένοι για όλες τις ειδήσεις και τα νέα από την Ελλάδα και τον κόσμο.